Texture et compression : mariage parfait ou cohabitation forcée

Par Karim El Katari, coloristeDurant son parcours chez Eclair, en collaboration avec Florine Bel et Thierry Beaumel, il a mis à disposition de ses collaborateurs un workflow pérenne basé sur l’utilisation de LMTs (Look Modification Transform) qui, à ce jour, correspond aux recommandations techniques des grands acteurs de la distribution.

Sa passion pour l’image se reflète également dans ses recherches personnelles en photographie, où il se livre à des expérimentations pour toujours remettre en question ses pratiques. Cette quête l’a poussé à s’aventurer outre-Atlantique depuis quelques années, afin de se confronter à d’autres méthodologies et problématiques propres à un marché différent du nôtre.

Malgré la distance, notre collaboration perdure, animée par des divergences d’opinions et des débats incessants dans le but commun de servir au mieux nos images. L’article qui suit est le fruit de l’un de nos débats, compte tenu de sa teneur il m’a semblé pertinent de vous le relayer. (Xavier Dolléans, AFC)

Avertissement : les contraintes d’affichage des images sur le Web, en particulier ici, sur le site Internet de l’AFC, ne permettent pas de percevoir correctement les subtilités de traitement du bruit numérique, de la texture et de la compression dont il est question dans cet article. Aussi, avons nous choisi de placer quand même quelques illustrations afin de rythmer la lecture, mais les images natives – en pleine résolution (TIFF 16 bits) – sont disponibles au téléchargement en cliquant sur ce lien. [NDLR]

Le temps passé

L’avènement des caméras numériques a bouleversé le paradigme des moult questionnements artistiques et techniques dans la confection des images. A ceci s’est ajouté la démocratisation des plateformes de streaming qui apporte son lot de questionnements concernant la diffusion de nos images. En tant qu’étalonneur, l’un de mes soucis premiers a toujours été que les choix faits dans les meilleures conditions de projection ou de diffusion soient le plus fidèlement retransmis au spectateur. Cette conscience vient peut-être de mon parcours débuté il y a plus de dix ans dans les laboratoires Eclair.

J’ai eu la chance de pouvoir apprendre et pratiquer l’étalonnage traditionnel (photochimique) lors des dernières années du procédé sur le sol français. L’une des plus grandes frustrations que j’ai eu à gérer lors de mes débuts, était le décalage d’exigence entre la précision d’étalonnage de la copie dite de référence (conçue avec réalisateurs et opérateurs), et la précision d’étalonnage des copies de série. Je ne suis pas obtu aux enjeux économiques qu’affrontait le département en charge des copies de séries à l’époque. Sans la marge qu’ils réalisaient, il nous aurait été impossible d’absorber les pertes liées à la précision exigée lors de l’étalonnage que l’on appelait de production (artistique).

A mon sens, ce revers de la médaille de la distribution des films en argentique a souvent été oublié. Et aujourd’hui, voir d’un bon œil l’avènement de la diffusion numérique pour les avantages techniques qu’elle représente, est encore à ce jour une opinion quelque peu décriée pour son manque de romantisme. Les copies DCP, les masters de streaming ont permis de démocratiser un standard de reproduction qui n’a jamais été aussi proche de ce que nous concevons en salle d’étalonnage, que ce soit en termes de dynamique, de piqué, de nuances de couleurs, et tous les autres éléments que l’on souhaiterait ajouter à cette liste, excepté, selon moi, la texture.

La texture est au centre de la réflexion de tous les acteurs de l’image depuis que les caméras numériques ont pris le dessus. La référence ultime reste l’imagerie argentique dans la grande majorité des productions ; que ce soit en long métrage, en série, en publicité, etc. J’ai la chance aujourd’hui de travailler dans l’un des derniers laboratoires à conserver une filière photochimique, à savoir MELS [Montréal]. Ceci m’a permis de rester au contact de cette sensibilité de l’argentique et conduire toute une série d’essais me permettant aujourd’hui de pouvoir proposer une pléthore de textures basée sur des procédés concrets de traitements photochimiques. Cet aspect créatif est passionnant et me permet d’accompagner l’ensemble des productions et de mes collaborateurs dans la création de l’identité visuelle du projet.

Le présent

Dans l’enceinte d’un laboratoire, où le mot compression n’a pas sa place, l’exigence et la précision sont les maîtres mots. Cependant, la technologie atteint ses limites, et je retrouve une frustration similaire à celle de la fabrication des copies de série à l’époque de l’argentique.

Que peut-on considérer comme faisant partie de la texture ? La granularité d’une image, le bruit numérique, le MTF d’une optique, la présence de "halation", la diffusion, les mécanismes de l’œil (corrélation contraste / perception de la netteté), peut-être même la palette de couleurs venant "matiérer" la composition de l’image… Voici une multitude de paramètres à notre disposition pour influer sur la texture d’une image, mais celui qui attire le plus l’attention et qui est le plus récurrent dans les demandes que je reçois lors de mes séances d’étalonnage, est bien évidemment le grain.

Qu’est-ce que le grain ou le bruit dans le monde numérique ?

C’est une valeur de pixels ou bien d’amas de pixels (selon la taille) dont la valeur change ou se déplace à chaque image. Dans un monde sans compression, nous ne serions confrontés à aucune problématique, mais qu’en est-il lorsque l’on est confrontés à des débits et des périphériques de diffusion divers et variés ?

Algorithme

C’est dans ce cas de figure que les fournisseurs de contenu sont tenus de trouver des solutions en optimisant les algorithmes de compression. L’évolution des algorithmes est axée sur l’amélioration de la perception qualitative de l’image pour un poids égal ou inférieur à la génération d’algorithme précédent. Un exemple parmi les plus marquants serait la différence entre le H264 et le H265.

Avant de continuer, je vais me permettre de citer une excellente explication du principe fondamental de ce qu’est une compression d’un signal vidéo tirée de Wikipedia :

« Les séquences vidéo contiennent une très grande redondance statistique, aussi bien dans le domaine temporel que dans le domaine spatial. La propriété statistique fondamentale sur laquelle les techniques de compression se fondent, est la corrélation entre pixels. Cette corrélation est à la fois spatiale, les pixels adjacents de l’image courante sont similaires, et temporelle, les pixels des images passées et futures sont aussi très proches du pixel courant.

Ainsi, on suppose que l’importance d’un pixel particulier de l’image peut être prévue à partir des pixels voisins de la même image (utilisant des techniques de codage intra-image) ou des pixels d’une image voisine (utilisant des techniques inter-image). Intuitivement il est clair que dans certaines circonstances, par exemple, lors d’un changement de plan d’une séquence vidéo, la corrélation temporelle entre pixels d’images voisines est petite, voire nulle. Dans ce cas, ce sont les techniques de codage dites Intra qui sont les mieux appropriées, afin d’exploiter la corrélation spatiale pour réaliser une compression efficace de données. »

Un autre facteur intéressant sur lequel les algorithmes se focalisent est notre faculté de perception, afin de compresser davantage les parties de l’image auxquelles l’œil est physiologiquement moins sensible, les ombres par exemple.

Afin que l’algorithme soit efficace, il est nécessaire d’avoir une corrélation entre pixels. Dans l’exemple du grain, cette corrélation est fondamentalement impossible, il en est de même pour le bruit numérique.

Mon constat de cette problématique remonte à 2013, à la découverte de la bande-annonce d’une super production hollywoodienne tournée en 35 mm avec un grain volontairement exacerbé. Le résultat sur les différentes plateformes de vision était tel, qu’une version dégrainée a rapidement remplacé la première et a été utilisée pour assurer des standards de qualité de diffusion. L’ensemble des bandes-annonces suivantes ont subi le même traitement. Depuis l’industrie outre-Atlantique semble s’être adaptée à ces contraintes par des moyens concrets, l’un d’entre eux est la différenciation des masters selon le médium de diffusion. C’est quelque chose que j’essaye d’appliquer depuis quelques années déjà, laisser libre cours à la volonté d’appuyer un grain fort sur les masters qui subiront le moins la compression, les DCPs pour les salles de cinéma par exemple, mais fortement déconseiller l’usage de grain sur les masters utilisés pour les diffusions plus compressées comme sur les plateformes de streaming.

Les normes sont extrêmement strictes concernant les débits à utiliser, ce qui implique que pour que notre image soit la moins altérée, la seule variable en notre possession est la texture.

Mais quels sont donc les conséquences concrètes sur une image granuleuse ou bruitée ? La compression traite l’image au niveau du pixel, donc dissocier le tandem grain/bruit de l’image est tout simplement irréalisable, le grain est interprété par l’algorithme de compression comme un détail dans l’image. Cette donnée implique qu’une partie conséquente du débit du flux vidéo est consacrée aux pixels en mouvement, ce qui réduit drastiquement la place disponible pour l’image en dehors de la texture.

Il en résulte une agglomération des valeurs de pixels qui conduit à l’altération de la colorimétrie et de la définition de l’image.

La perte radicale de la précision colorimétrique nous amène à une perception d’une image délavée étant donné que la séparation de couleur est moins nuancée. Le contraste subit le même sort. Le piqué quant à lui est sévèrement endommagé, il m’est arrivé lors de tests comparatifs de deux masters UHD avec des compressions volontairement différentes, d’avoir la sensation de regarder une image UHD face à une autre en 720p. Cette sensation a été partagée par de nombreuses personnes à qui j’ai pu montrer ce comparatif.

Dans les cas que j’ai rencontré sur mes projets, il m’est apparu que si une image granuleuse/bruitée contenait de la diffusion, ou de la "halation", d’autres conséquences étaient à noter. La perte de piqué liée à la compression conduisait à un changement de perception. La diffusion et/ou la "halation" se trouvaient être exacerbées à l’extrême en comparaison avec le master sans compression.

L’un des facteurs les plus dérangeants qui vient s’additionner à la liste est l’apparition de macro-blocs. Les macro-blocs sont un amas de pixels (16x16 concrètement, mais dans le jargon des défauts visuels ce sont des amas bien plus grands) qui peuvent être issus d’un rafraîchissement en décalage avec la diffusion du contenu. Ces pixels appartiennent à l’image précédente, voire dans les cas extrêmes à quelques images avant (dans le cas d’artéfacts temporels).

Le comble de toutes les problématiques que je cite est que le grain, étant impossible à être restitué par la compression, se voit selon sa taille, gommé (grain fin ou léger), figé, voire ralenti autour des éléments en mouvement dans l’image (grain de taille plus marquée). Dans le cas du grain plus visible, le fait d’avoir des variations de rafraîchissements du grain, conduit à une sensation de texture au ralenti par rapport au défilement du contenu de l’image.

Je choisis volontairement de lister des éléments perceptuels afin de ne pas rendre cette lecture indigeste, mais il me semble important d’intégrer quelques éléments techniques qui expliquent les phénomènes que je cite.

En préparant cet article, j’ai approfondi ma connaissance de certains concepts de fabrication pour le moins intéressants, celui de la librairie de codec, mais aussi le concept des codecs lossy et lossless.

Nous sommes au contact des codecs lossy et lossless au quotidien, les "lossy", comme leur nom l’indique, sont des codecs subissant une perte d’information. Ils existent pour être facilement transportables (streaming, envois de fichiers…). A la base de leur fonction, la perte d’information se doit d’être la plus invisible à l’œil (tant que le débit reste suffisant).

Les codecs "lossless", quant à eux, sont ceux que nous privilégions dans nos séances de travail car l’ensemble de l’information doit y être préservée malgré les mêmes principes de compression grâce à la redondance statistique des valeurs de pixels.

A ces deux variables s’ajoute le concept de librairie de codec. Chaque encodeur ou décodeur possède une librairie propre pour chaque codec de son répertoire.

Un logiciel "A" utilisera une librairie qui lui est propre concernant le codec choisi, un logiciel "B" en utilisera une autre qui lui est propre pour fabriquer le même codec. Lorsque les débits sont réduits, les écarts de conception et de qualité des librairies sont de plus en plus marqués.

Ces différences sont également présentes, si la librairie de l’encodeur est dite "librairie A" et que le décodeur (périphérique de diffusion) sollicite une "librairie B".

La quantité de variables sur la diffusion augmente très rapidement selon cette logique.

Les diverses librairies de codecs lossy ont toutes en commun des difficultés de gestion des hautes fréquences de l’image, en d’autres termes, les détails les plus fins.

C’est pour cette raison que certains acteurs de la compression intègrent un pré-traitement destiné à réduire une bonne partie des hautes fréquences avant la compression.

Le moyen utilisé est l’ajout d’un léger blur sur la totalité de l’image. L’image est donc moins détaillée ou texturée.

Je précise tout de même que malgré cette intervention sur l’image, le résultat qualitatif de la compression est logiquement meilleur qu’une compression sans pré-traitement. Il va sans dire que ce pré-traitement n’est pas accessible à tous, car étant une étape supplémentaire, le coût de celle-ci n’est absorbé que par les plus grosses productions.

Dans le cas d’une image granuleuse ou bruitée, selon le débit alloué au codec lossy, selon la librairie d’encodage, selon la librairie de décodage, le comportement des pixels variera, et c’est alors que nous sommes confrontés à toute une variété d’artéfacts spatiaux et temporels qui vont altérer notre perception.

Tous ces éléments sont une accumulation de défauts qui ne font que fausser et créer un écart entre la vision des créatifs et celle du spectateur.

Comment se fait-il que les QC (contrôle de qualité) demandés par les chaînes et les diffuseurs ne relèvent rien de ce que je cite ?

La raison est simple, l’analyse est faite sur le master vidéo à peine compressé (ProRes 422HQ dans la majorité des cas – considéré comme virtuellement lossless) sorti du laboratoire. L’image est extrêmement fidèle à tout ce qui a été conçu auparavant. Mais ce qui arrive comme flux chez tout un chacun, est l’un des masters réencodés et donc compressés, propre au débit et au type d’écran utilisé. Ces masters-là sont extrêmement nombreux car ils peuvent aller de la résolution UHD à 360p, et être en HDR ou SDR.

A la différence des masters fabriqués en laboratoire, les masters compressés ne subissent pas de contrôle qualité rigoureux.

A tout cela s’ajoutent la différence de qualité exigée par les plateformes et le savoir-faire de compression qu’elles mettent en œuvre pour chacune de leurs productions (cf. librairies de codecs).

Le type de ré-encodage des masters par les plateformes est peu documenté même si pour les professionnels du secteur, il est possible de deviner la méthode employée. Les qualités sont variables et ont donc une influence considérable sur le résultat final de la diffusion.

Exercice pratique

Il m’est impossible d’étayer mes propos avec des images de productions pour des questions de droits mais également pour ne pas pointer des projets spécifiquement.

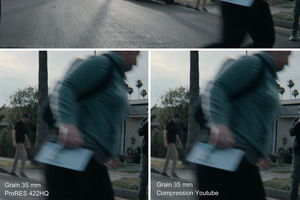

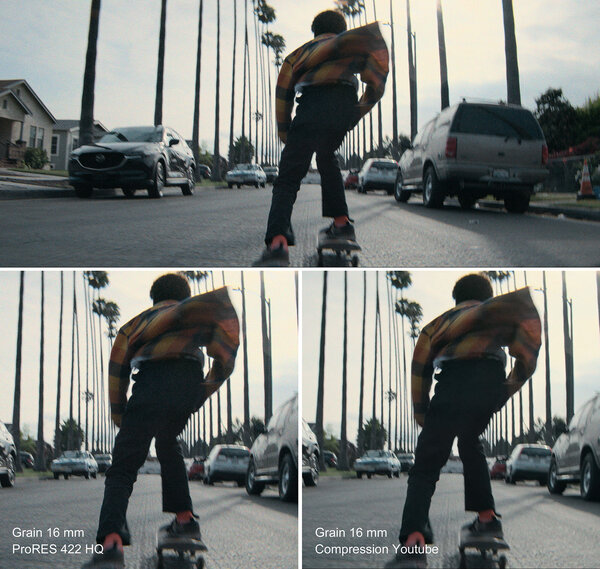

Pour m’aider à illustrer mes propos, mon collaborateur Xavier Dolléans a eu la gentillesse de convaincre les frères Hicham et Samir Harrag, que je remercie chaleureusement, de bien vouloir me faire parvenir un rushe de leur plus récent projet, Speaker Boy. Le film a été tourné en Sony Venice 1 couplé à une série Atlas Mercurey Anamorphique 1.5.

Le processus est assez simple, j’ai traité le RAW (6048x4032) de la Sony Venice 1 à l’aide d’un Baselight dans une chaîne Aces en ajoutant la LMT correspondant à la LUT de tournage utilisée par Xavier. J’ai répliqué le plan trois fois afin d’avoir une version neutre et deux versions avec une recette de grain (correspondant à un négatif 200T 35 mm et 16 mm).

Pour l’étape suivante, j’ai exporté un ProRes422HQ en UHD que j’ai publié sur YouTube, puis j’ai téléchargé l’encodage le plus qualitatif réalisé par la plateforme. Pour finir j’ai extrait des captures de chaque fichier, les premières issues du ProRes et les secondes de l’encodage YouTube. Ces captures mettent en évidence certains des défauts que je cite plus haut.

Cependant, mis à part constater des défauts figés sur une image arrêtée, ces exemples ne vous permettront pas de juger du rendu si particulier lorsque l’image est en mouvement. Ayant ces exemples à l’appui, je recommande de chercher à juger d’une comparaison de texture sur des images animées. Je vous propose une autre démarche, similaire à celle que j’ai pu réaliser avant l’écriture de cet article et que tout un chacun peut entreprendre.

Les masters subissant les compressions les plus qualitatives et restant accessibles à tous, sont les Blu-ray 4K. Il suffit de se procurer un Blu-ray 4K d’un ou plusieurs films comportant du grain, et de comparer le même master 4K (UHD dans les faits) sur la plateforme de streaming le proposant.

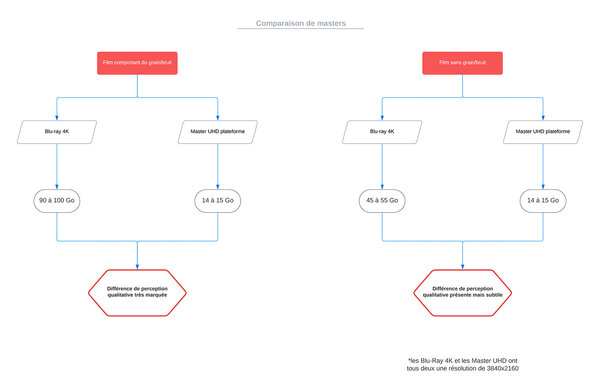

Le rapport de poids d’un film de deux heures avec du grain est d’environ 90 à 100 Go sur un Blu-ray 4K lorsqu’en streaming la meilleure des qualités proposées est de 14/15 Go. Je reprécise et j’insiste sur le fait qu’il existe ensuite toutes les déclinaisons plus légères et donc de moins bonne qualité. La différence de qualité est visible même pour un public non averti.

Ma démarche ne s’arrête pas là puisque j’ai également réalisé la comparaison sur des projets que l’on pourrait considérer comme plus lisses, sans grain et sans bruit numérique.

Le rapport de poids est très différent puisque l’on peut constater avoir des films de deux heures sur un Blu-ray 4K pesant entre 45 et 55 Go pour toujours un poids de 14/15Go sur les meilleures plateformes de streaming. (voir schéma 1)

Sans la variable de grain et de bruit, les algorithmes sont plus à même de fonctionner de manière optimale et de fournir une image similaire à celle créée en amont.

L’écart de qualité entre les deux masters "à images lisses" est infiniment moins flagrant que lorsque les masters comparés comportent du grain/bruit.

Quelles solutions ?

A ma connaissance, il existe une plateforme qui à ce jour propose à ses créatifs de réaliser un test sur une chenille (extrait pour les plus jeunes) de leur projet, avec et sans grain. Une fois cette chenille mise en ligne sur la plateforme de diffusion, il leur est possible de comparer les deux versions, sur différents écrans mais aussi en paramétrant les différentes qualités que recevront les spectateurs ne bénéficiant pas des meilleures conditions de réception. Cette méthode donne la possibilité à tous de prendre les décisions créatives en connaissance du résultat visuel sur l’ensemble de la chaîne de diffusion.

A mon sens, c’est un service essentiel qui se devrait d’être généralisé pour que les décisions soient prises avec des images à l’appui et non sur la méconnaissance de la chaîne post créative.

Il est légitime de se tourner vers les normes de débit, et de chercher à ce que les débits augmentent pour régler le problème que j’évoque, mais où devrions nous fixer les curseurs ? Plus les débits seront élevés, plus les besoins matériels de diffusion augmenteront et une partie des spectateurs potentiels pourraient se retrouver dans l’impossibilité d’accéder au contenu.

J’ai par ailleurs lors de la rédaction de cette réflexion, échangé avec un bon nombre de personnes sensibles à la qualité du transport du pixel dans la chaîne de diffusion. Leur point de vue était en contrepoint avec la pensée commune qui est : « Une plus grande résolution équivaut à une meilleure qualité ».

Si à codec égal, le choix vous est laissé entre un master compressé en HD et un autre en UHD, vers lequel tendriez-vous ?

Si à ce choix nous ajoutons une donnée supplémentaire, le master HD et UHD sont encodés à 25 Mbps.

L’image UHD étant quatre fois plus détaillée, elle sera bien plus compressée à débit similaire. Ajoutons à ces données l’intégration de texture… Le tableau noircit à vue d’œil.

Le marketing des fabricants et constructeurs remplit extrêmement bien son rôle. Sans trop y penser, n’importe qui aurait tendance à viser une diffusion avec une plus grande résolution pour obtenir une meilleure qualité. Et pourtant, nous sommes constamment confrontés à un autre exemple ; un DCP 4K pèse le même poids qu’un DCP 2K. La version 4K est donc bien plus compressée que la version 2K.

Je tempère cet exemple car l’écart de qualité entre les deux versions est bien moins marqué que sur les masters destinés à une distribution télévisuelle car le JPEG2000 est considéré comme un codec lossless.

Pistes de reflexions

Mais quelles seraient donc les pistes de réflexion que l’on pourrait attendre de la part des fabricants/diffuseurs ?

Nous avons de tout temps été limités par différentes contraintes de diffusion, la luminosité maximale et minimale, la résolution, le gamut de couleur… La compression et son débit alloué ne sont qu’un énième élément qui vient s’ajouter à la liste.

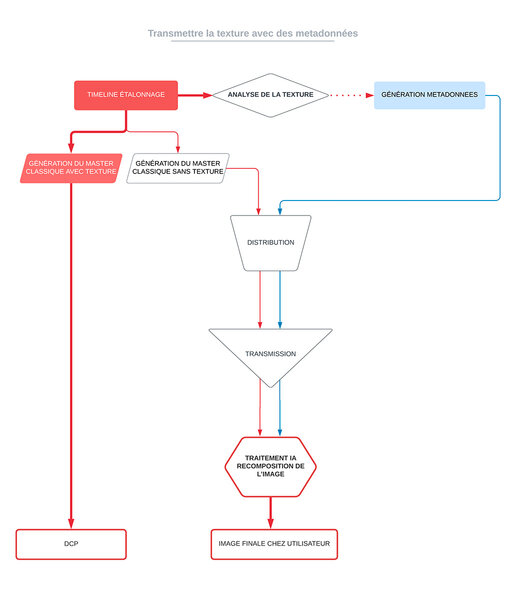

Pour contourner cette limitation, une idée quelque peu farfelue nous permettrait d’imaginer une décorrélation entre l’image et sa texture. Les deux éléments seraient distribués en deux flux distincts et réassemblés par le périphérique de diffusion. Ce genre de procédé est à la base des techniques de restauration de films, donc elle n’aurait rien de novateur en termes de concept. Le flux ne contenant que l’image subirait une compression optimale, la texture quant à elle rencontrerait toujours la même problématique de saturation de la bande passante allouée à la compression.

Dans ce cas, nous pourrions nous inspirer du procédé Dolby Vision et de son transport d’image couplé à des métadonnées d’interprétation pour le périphérique de diffusion.

Est-ce qu’à l’ère de l’intelligence artificielle nous pourrions envisager une étape d’analyse supplémentaire ?

Lors de la masterisation nous pourrions imaginer une analyse de la texture souhaitée, qui serait ensuite traduite sous forme de métadonnées.

Ces métadonnées transiteraient avec l’image sans texture jusqu’au périphérique de diffusion. Le périphérique pourrait générer une texture dénuée de compression à l’aide des métadonnées et l’intégrer à l’image dénuée de texture. (voir schéma 2)

Il ne serait pas insensé d’imaginer qu’avec un semblant de recherche dans cette direction, les générateurs de texture basés sur de l’intelligence artificielle, pourraient nous fournir des résultats proches du master en sortie de laboratoire, au point d’être indiscernables.

Tout ce questionnement est grandement motivé par le fait que la répartition du temps de diffusion octroyée à nos images, est de plus en plus à l’avantage du petit écran. A mon sens, lorsque les limitations liées à la diffusion sont prises en compte, il nous est possible d’obtenir une qualité de diffusion chez le particulier jamais atteinte par le passé. La quantité de nuances présentes sur un master UHDR que ce soit dans les couleurs, les ombres, les blancs, le détail et j’en passe, est absolument phénoménal. Le revers de la médaille est d’autant plus amer lorsque les limitations sont ignorées.

Je ne prêche pas pour l’arrêt de l’utilisation de la texture, loin de là. Je prêche pour une utilisation du grain en particulier ; tenant compte des limitations de diffusion que vont subir nos images. La texture quant à elle ne se limite pas au grain et au bruit comme je l’écrivais plus haut. Nous avons aujourd’hui une palette d’outils particulièrement variée au service de notre créativité pour définir la texture de nos images sans que la vision de celles-ci ne puisse être compromise.

La liberté de créativité existe dans les limites des contraintes actuelles des moyens de diffusion. Lorsque les contraintes sont respectées, cet écosystème fonctionne mais sur un équilibre précaire. C’est ici que je pose la question, quels moyens pourrions-nous attendre de la part des diffuseurs afin de nous aider à prendre des décisions artistiques à la lumière de leurs contraintes techniques ?

En

En Fr

Fr